Ad click e distopia: l’algoritmo del desiderio

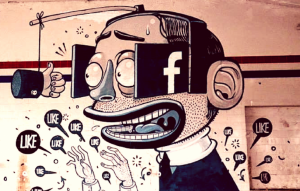

Stiamo costruendo una distopia basata sull’intelligenza artificiale, un clic alla volta, dice la tecno-sociologa Zeynep Tufekci. In un intervento rivelatore, ci spiega come in aziende come Facebook, Google e Amazon gli stessi algoritmi utilizzati per attirare clic sulle pubblicità vengono usati anche per organizzare l’accesso a informazioni politiche e sociali. E non sono le macchine la vera minaccia. Dobbiamo capire come chi ha potere potrebbe utilizzare l’Intelligenza Artificiale per controllarci — e le misure che possiamo prendere.

L’INTERVENTO: “Quando la gente dà voce alle paure legate all’intelligenza artificiale, molto spesso evoca immagini di robot umanoidi usciti fuori controllo. Avete presente Terminator? Potrebbe essere una possibilità da considerare, ma si tratta di una minaccia remota. Oppure, ci agitiamo per il controllo digitale usando metafore del passato. “1984” di George Orwell è di nuovo tra i bestseller. È un gran libro, ma non è la corretta distopia da applicare al 21esimo secolo. Ciò che dobbiamo temere non è cosa l’intelligenza artificiale possa fare di per sé, ma come le persone di potere potranno utilizzarla per controllarci e manipolarci in modi nuovi, talvolta nascosti, sottili e inaspettati. Gran parte della tecnologia che mette a rischio la nostra libertà e dignità nel futuro imminente viene sviluppato da aziende che guadagnano catturando e rivendendo i nostri dati e attenzione a inserzionisti e altre entità: Facebook, Google, Amazon, Alibaba, Tencent.

Ora l’intelligenza artificiale comincia a rafforzare il loro business. E sembrerebbe che l’intelligenza artificiale sia il passo successivo alla pubblicità online. Non lo è. È un salto di categoria. È un mondo totalmente differente, con un grosso potenziale. Potrebbe accelerare la nostra comprensione in molte aree di studio e di ricerca. Ma per parafrasare un famoso filosofo di Hollywood, “Da un grande potenziale derivano grandi rischi”

Guardiamo a un fatto semplice delle nostre vite digitali, la pubblicità. Giusto? Tendiamo a ignorarle. Sembrano rozze, di scarso effetto. Tutti abbiamo avuto la sensazione di essere inseguiti sul web da pubblicità basate su cose che abbiamo cercato o letto. Lo sapete, cercate un paio di stivali e per giorni, questi stivali vi seguiranno dovunque andiate. Persino quando cedete e li acquistate, continueranno a seguirvi ancora. Siamo quasi abituati a questo tipo di manipolazione grossolana. Alziamo gli occhi e pensiamo, “Sai? Queste cose non funzionano.” Tranne che, online, le tecnologie digitali non sono solo pubblicità. Per capire meglio, prendiamo un esempio del mondo fisico. Sapete che nei supermercati, proprio vicino alle casse trovate dolci e gomme ad altezza occhi di bambino? È fatto apposta per farli piagnucolare proprio mentre i genitori stanno per pagare alla cassa. Questa è architettura persuasiva. Non è bella, ma funziona. E infatti la vedete in tutti i supermarket. Nel mondo reale, queste architetture persuasive sono un po’ limitate, perché si può caricare fino a un certo punto l’angolo della cassa. Inoltre dolci e gomme, sono uguali per tutti, anche se funziona di più per le persone che hanno piccoli bimbi frignanti accanto. Nel mondo fisico, viviamo con queste limitazioni.

Guardiamo a un fatto semplice delle nostre vite digitali, la pubblicità. Giusto? Tendiamo a ignorarle. Sembrano rozze, di scarso effetto. Tutti abbiamo avuto la sensazione di essere inseguiti sul web da pubblicità basate su cose che abbiamo cercato o letto. Lo sapete, cercate un paio di stivali e per giorni, questi stivali vi seguiranno dovunque andiate. Persino quando cedete e li acquistate, continueranno a seguirvi ancora. Siamo quasi abituati a questo tipo di manipolazione grossolana. Alziamo gli occhi e pensiamo, “Sai? Queste cose non funzionano.” Tranne che, online, le tecnologie digitali non sono solo pubblicità. Per capire meglio, prendiamo un esempio del mondo fisico. Sapete che nei supermercati, proprio vicino alle casse trovate dolci e gomme ad altezza occhi di bambino? È fatto apposta per farli piagnucolare proprio mentre i genitori stanno per pagare alla cassa. Questa è architettura persuasiva. Non è bella, ma funziona. E infatti la vedete in tutti i supermarket. Nel mondo reale, queste architetture persuasive sono un po’ limitate, perché si può caricare fino a un certo punto l’angolo della cassa. Inoltre dolci e gomme, sono uguali per tutti, anche se funziona di più per le persone che hanno piccoli bimbi frignanti accanto. Nel mondo fisico, viviamo con queste limitazioni.

Nel mondo digitale, invece, le architetture persuasive possono essere costruite su larghissima scala e possono colpire, dedurre, capire essere su misura per singoli individui uno per uno scoprendo le debolezze, e possono essere inviate sugli schermi privati dei nostri telefoni, così da non essere visibili. E questo è differente. Questa è una delle cose basilari che l’intelligenza artificiale può fare.

Facciamo un esempio. Poniamo caso vogliate vendere voli verso Las Vegas, ok? Nel vecchio mondo, potreste pensare a un target demografico da colpire basato sull’esperienza e su alcune supposizioni. Avreste diretto la pubblicità a uomini tra i 25 e i 35, o persone con un plafond alto nelle carte di credito o coppie in pensione.Giusto? Questo è ciò che avreste fatto ieri.

Grazie a Big Data e Machine Learning, non funziona più così. Per aiutarvi a capire, pensate a tutti i dati che Facebook ha su di voi: tutti gli aggiornamenti che avete scritto, tutte le chat su Messenger, i posti da cui vi siete collegati, tutte le foto che avete aggiunto. Se cominciate a scrivere qualcosa e poi ci ripensate e cancellate, Facebook conserva e analizza anche quello. Prova sempre di più a collegarvi con i vostri dati offline. E compra pure dei dati da altri fornitori esterni. Dati di varia natura come movimenti finanziari o la storia delle pagine che avete visitato. Negli Stati Uniti questi dati vengono raccolti con regolarità, esaminati e rivenduti. In Europa le leggi sono più restrittive.

Quindi, ciò che accade macinando tutti questi dati, gli algoritmi “machine learning” proprio per questo sono chiamati algoritmi di “apprendimento” apprendono come capire le caratteristiche della gente che ha comprato in precedenza biglietti per Las Vegas Così come imparano dai dati esistenti, imparano anche come applicarlo a nuove persone. Quindi quando si trovano davanti un nuovo soggetto possono classificarlo e dire se vorrebbe o meno un biglietto per Las Vegas Bene. Starete pensando, un’offerta su un volo per Las Vegas. Posso ignorarla. Ma non è quello il problema. Il problema è che non riusciamo più a capire come funzionano questi algoritmi complessi non capiamo come facciano questa categorizzazione. Sono matrici giganti, con migliaia di righe e colonne, forse milioni di righe e colonne, e né i programmatori né nessuno di quelli che ha accesso, anche se possiede tutti i dati, capisce più come stia funzionando esattamente non più di quanto voi potreste capire a cosa sto pensando ora se vi fosse mostrata una sezione del mio cervello. È come se non programmassimo più, ma accresciamo un’intelligenza che non riusciamo a capire davvero.

Tutto questo funziona solo attraverso un’enorme quantità di dati, cosicché viene favorito un controllo approfondito su tutti noi per far funzionare gli algoritmi di apprendimento Per questo Facebook vuole raccogliere tutti i vostri dati. L’algoritmo funziona meglio.

Tutto questo funziona solo attraverso un’enorme quantità di dati, cosicché viene favorito un controllo approfondito su tutti noi per far funzionare gli algoritmi di apprendimento Per questo Facebook vuole raccogliere tutti i vostri dati. L’algoritmo funziona meglio.

Spingiamo ancora di più l’esempio di Las Vegas. E se questo sistema che non riusciamo a comprendere avesse imparato che è più semplice vendere biglietti per Las Vegas a persone bipolari e sul punto di entrare nella fase maniacale. Queste persone tendono a spendere di più e a diventare scommettitori compulsivi. Potrebbero pescare da quel bacino e nessuno potrebbe mai saperlo. Ho fatto questo esempio a un gruppo di ingegneri, una volta e subito dopo, uno di loro è venuto da me. Era turbato e mi disse, “ecco perché non posso pubblicarlo” E io, “Non pubblicare cosa?” Aveva provato a vedere se fosse possibile comprendere uno stato maniacale dai post sui social media prima dei sintomi clinici, e aveva funzionato, aveva funzionato benissimo, e lui non aveva idea di come funzionasse e cosa stesse pescando.

Il problema non si risolve se lui non pubblica il software, perché ci sono già aziende che stanno sviluppando questo tipo di tecnologia, e una buona parte è già disponibile. Non è più una cosa complicata.

Andate mai su YouTube con l’idea di guardare un video e un’ora dopo ne avete guardati 27? Sapete che YouTube ha questa colonna sulla destra che dice “Prossimi video” e poi ne parte in automatico un altro? È un algoritmo che sceglie qualcosa che pensa possa interessarvi che magari non trovate da soli. Non è un editor umano. Lo fa un algoritmo. Studia quello che avete guardato voi e le persone simili a voi e desume quello che potrebbe interessarvi, cosa vorreste di più, e ve ne mostra di più. Sembra una funzionalità innocua e utile tranne quando non lo è.

Nel 2016, ho partecipato a raduni dell’allora candidato Donald Trump per studiare accademicamente il movimento che lo supportava. Studio movimenti sociali, così studiavo anche quello. Volevo scrivere qualcosa su uno di quei raduni, e l’ho guardato qualche volta su YouTube. YouTube ha cominciato a raccomandarmi e a far partire video sui suprematisti bianchi in crescente ordine di estremismo. Ne guardavo uno, me ne proponeva uno ancora più estremo che partiva in automatico. Se guardi contenuti di Hillary Clinton o di Bernie Sanders YouTube raccomanda e fa partire video cospirazionisti di sinistra, e da lì sempre più giù.

Bene, potreste pensare, questa è politica. Ma non lo è. Non si tratta di politica. Si tratta di un algoritmo che ha compreso la natura umana. Una volta ho guardato un video sul vegetarianismo su YouTube e YouTube mi ha consigliato un video sull’essere vegani. È come se non ci credete mai abbastanza per YouTube

Allora cosa succede? Anche se l’algoritmo di YouTube è proprietario ecco cosa penso stia accadendo. L’algoritmo ha capito che se puoi attrarre la gente a pensare che puoi mostrargli qualcosa di ancora più spinto, la gente rimarrà sul sito con maggiore probabilità guardando video dopo video scendendo giù nella tana del coniglio mentre Google mostra le pubblicità. Mentre nessuno si accorge dei risvolti etici, questi siti possono profilare persone che odiano gli ebrei, che pensano che gli ebrei siano parassiti e chi ha contenuti antisemiti così espliciti, e vi consente di usarli come bersaglio per le pubblicità. Possono anche sguinzagliare gli algoritmi per trovare per voi gruppi di utenti simili, gente che sebbene non mostri contenuti antisemiti così espliciti viene riconosciuta dall’algoritmo come sensibile a questo tipo di messaggi, e vi fa bersagliare anche loro. Questo potrebbe sembrare un esempio poco plausibile, però è davvero reale. ProPublica ha investigato e scoperto che è possibile farlo davvero su Facebook e che Facebook amichevolmente ha dato suggerimenti su come espandere quest’audience. BuzzFeed ha provato a farlo con Google, e ha subito scoperto che sì, si può fare anche su Google. E che non era nemmeno caro. Il giornalista di ProPublica ha speso circa 30 dollari per colpire questa categoria.

Il Social Media Manager di Trump ha rivelato che l’anno scorso hanno utilizzato i post nascosti di Facebook per smobilitare la gente, non per persuaderla, ma per convincerla di non votare affatto. E per farlo, hanno preso come target specifico per esempio, uomini afroamericani in città chiave come Philadelphia e ora vi leggo esattamente quello che ha detto. Sto citando.

Stavano utilizzando, “Post non pubblici la cui audience è controllata nella campagna in modo tale che solo gente che noi vogliamo che veda, vedrà. L’abbiamo costruita così. Questo aumenterà enormemente la capacità di spegnere queste persone.”

Stavano utilizzando, “Post non pubblici la cui audience è controllata nella campagna in modo tale che solo gente che noi vogliamo che veda, vedrà. L’abbiamo costruita così. Questo aumenterà enormemente la capacità di spegnere queste persone.”

Cosa c’era in questi post nascosti? Non ne abbiamo la minima idea. Facebook non ce lo dirà.

L’algoritmo di Facebook dispone i post che i vostri amici o le pagine che seguite pubblicano. Non ve li mostra in ordine cronologico. L’algoritmo li riordina in modo tale che vi inducano a stare più a lungo sul sito.

E questo ha molte conseguenze. Potreste pensare che qualcuno vi stia ignorando su Facebook. L’algoritmo potrebbe non mostrare mai i vostri post. L’algoritmo dà priorità ad alcuni di loro e seppellisce gli altri.

Esperimenti mostrano che ciò che l’algoritmo sceglie di mostrarvi può influenzare le vostre emozioni. E non è tutto. Può influenzare il comportamento politico. Così nel 2010, durante le elezioni di metà mandato, Facebook ha fatto un esperimento su 61 milioni di americani che è stato reso pubblico subito dopo. Ad alcuni veniva mostrata “Oggi è il giorno delle elezioni”, la più semplice, mentre ad altri veniva mostrata quella con una piccola variazione con le piccole foto degli amici che hanno cliccato su “Ho votato”. Questa semplice modifica. Ok? Le foto erano l’unica modifica, e quei post mostrati una volta sola hanno portato altri 340 000 votanti in quella elezione, secondo questa ricerca, come confermato dalle liste degli elettori. Una coincidenza? No. Perché nel 2012, hanno ripetuto lo stesso esperimento. E quella volta, quel messaggio civico mostrato una sola volta ha portato altri 270 000 votanti. Per la cronaca, nel 2016 le elezioni presidenziali negli USA sono state decise da circa 100 000 voti. Facebook può anche dedurre le vostre inclinazioni politiche anche se non le avete mai esposte esplicitamente. Gli algoritmi possono farlo facilmente. Cosa accade se una piattaforma con questo tipo di potere decide di “spegnere” i sostenitori di un candidato in favore dell’altro? Come potremmo mai accorgercene?

Siamo partiti da qualcosa che sembrava innocuo – le pubblicità che ci seguono dappertutto – e siamo arrivati a qualcos’altro. Come pubblico e come cittadini, non sappiamo più se stiamo guardando le stesse informazioni o cosa stiano vedendo gli altri e senza una base comune d’informazione a poco a poco, il dibattito pubblico sta diventando impossibile, e siamo appena agli stadi iniziali di tutto questo. Questi algoritmi possono facilmente dedurre cose come l’etnia, il pensiero politico e religioso, la personalità l’intelligenza, la felicità, l’uso di sostanze che danno dipendenza le separazioni dei genitori, l’età e i sessi, solo dai like messi su Facebook. Questi algoritmi possono identificare i manifestanti anche se le loro facce sono parzialmente nascoste. Questi algoritmi possono essere capaci di capire l’orientamento sessuale solo dalla foto di profilo nei siti d’incontri.

Certo, queste sono sempre deduzioni probabilistiche, quindi non arrivano a una precisione del 100 per cento ma non credo che chi ha potere resista alla tentazione di usare queste tecnologie solo perché esiste qualche falso positivo, cosa che produrrà un’altra serie di problemi. Immaginate cosa possa fare uno stato con l’immensa quantità di dati che possiede sui propri cittadini. La Cina sta già utilizzando tecnologie di riconoscimento facciale per identificare e arrestare persone. Ed ecco la tragedia: costruiamo questa infrastruttura di controllo autoritario solo per ottenere clic sulle pubblicità. E questo non sarà un autoritarismo alla Orwell. Questo non è “1984”. Se l’autoritarismo utilizza evidenti meccanismi del terrore per spaventarci, saremo spaventati, ma sapremo perché, odieremo e resisteremo. Ma se le persone con potere usano questo algoritmi per osservarci placidamente, per giudicarci e per spingerci, per predire e identificare i piantagrane e i ribelli, per costruire un’architettura della persuasione su larga scala e per manipolare gli individui uno ad uno utilizzando le loro debolezze e vulnerabilità individuali, e se lo fanno su larga scala attraverso i nostri schermi privati cosicché non sappiamo neppure quello che i nostri concittadini e vicini stanno vedendo, questo autoritarismo ci avvolgerà come tela di ragno senza che ce ne rendiamo conto.

La capitalizzazione di borsa di Facebook sta raggiungendo il mezzo trilione di dollari. È perché funziona benissimo come architettura persuasiva. Ma la struttura di questa architettura è la stessa sia che voi vendiate scarpe o che stiate vendendo politica. L’algoritmo non ne conosce la differenza. Questi stessi algoritmi che vengono scatenati su di noi per renderci più malleabili alle pubblicità organizzano i nostri flussi d’informazione politica, personale e sociale e questo è ciò che dovrebbe cambiare.

Non mi fraintendete, usiamo le piattaforme digitali perché ci forniscono grande valore. Uso Facebook per tenere contatti con amici e familiari in tutto il mondo. Ho scritto di come siano importanti i social media per i movimenti sociali. Ho studiato come queste tecnologie possono essere utilizzate per aggirare la censura nel mondo. Non credo che le persone che guidano Facebook e Google stiano maliziosamente e deliberatamente tentando di rendere il paese o il mondo più polarizzati incoraggiando gli estremismi. Ho letto molte frasi piene di buone intenzioni pronunciate da queste persone. Ma non sono le intenzioni o le frasi di costoro a fare differenza, ma le strutture e i modelli di business che costoro stanno costruendo. E questo è il nocciolo del problema. O Facebook è una truffa gigante da mezzo trilione di dollari dove le pubblicità non funzionano e non funziona come un’architettura persuasiva o il suo potere d’influenza è fonte di grande preoccupazione. O l’uno, o l’altro. Per Google la storia è simile.

Quindi, cosa possiamo fare? Serve un cambiamento. Quindi. Non posso offrire una ricetta semplice, perché dobbiamo ristrutturare per intero il modo in cui opera la tecnologia digitale. Tutto: dal modo in cui la tecnologia viene sviluppata alla maniera in cui gli incentivi, economici o di altro tipo, sono costruiti dentro il sistema. Dobbiamo confrontarci e occuparci della mancanza di trasparenza creata dagli algoritmi proprietari, la sfida strutturale dell’opacità del “machine learning”, tutti questi dati su di noi che vengono raccolti indiscriminatamente. Abbiamo un grande compito di fronte a noi. Dobbiamo mobilitare la nostra tecnologia, la nostra creatività e sì, la nostra politica così da costruire un’intelligenza artificiale che ci supporti negli obiettivi umani ma che sia anche vincolata dai nostri valori umani. Capisco che non sarà semplice. Potremmo non accordarci facilmente sul significato di questi termini. Ma se prendiamo seriamente come operano questi sistemi da cui dipendiamo così tanto, non vedo come possiamo rimandare ancora questa discussione. Queste strutture stanno organizzando il modo in cui funzioniamo e stanno controllando ciò che possiamo e non possiamo fare. Molte piattaforme che si finanziano con pubblicità. si vantano di essere gratuite. In questo contesto, significa che noi siamo i prodotti da vendere. Serve un’economia digitale dove i nostri dati e la nostra attenzione non sono venduti al miglior offerente autoritario o demagogo.

Quindi, cosa possiamo fare? Serve un cambiamento. Quindi. Non posso offrire una ricetta semplice, perché dobbiamo ristrutturare per intero il modo in cui opera la tecnologia digitale. Tutto: dal modo in cui la tecnologia viene sviluppata alla maniera in cui gli incentivi, economici o di altro tipo, sono costruiti dentro il sistema. Dobbiamo confrontarci e occuparci della mancanza di trasparenza creata dagli algoritmi proprietari, la sfida strutturale dell’opacità del “machine learning”, tutti questi dati su di noi che vengono raccolti indiscriminatamente. Abbiamo un grande compito di fronte a noi. Dobbiamo mobilitare la nostra tecnologia, la nostra creatività e sì, la nostra politica così da costruire un’intelligenza artificiale che ci supporti negli obiettivi umani ma che sia anche vincolata dai nostri valori umani. Capisco che non sarà semplice. Potremmo non accordarci facilmente sul significato di questi termini. Ma se prendiamo seriamente come operano questi sistemi da cui dipendiamo così tanto, non vedo come possiamo rimandare ancora questa discussione. Queste strutture stanno organizzando il modo in cui funzioniamo e stanno controllando ciò che possiamo e non possiamo fare. Molte piattaforme che si finanziano con pubblicità. si vantano di essere gratuite. In questo contesto, significa che noi siamo i prodotti da vendere. Serve un’economia digitale dove i nostri dati e la nostra attenzione non sono venduti al miglior offerente autoritario o demagogo.

Così, tornando indietro a quella parafrasi di Hollywood, noi vogliamo che il potenziale prodigioso dell’intelligenza artificiale e della tecnologia digitale fiorisca, ma per farlo, dobbiamo affrontare questa grande minaccia, con occhi ben aperti. (dall’intervento di Zeynep Tufekci)